人工智能突飞猛进的发展,推动了服务器、算力芯片需求的爆发。根据国产AI服务器的专家交流纪要,截止4月,AI服务器整个行业接单Q1同比增长40%左右,历史上每年Q1(Q1是淡季)同比增长16%-20%,今年AI服务器的市场需求很大,全年40%增长是比较保守的。我们就来看看服务器和算力芯片领域相关公司。

大模型是人工智能发展的必然趋势:大模型即“大算力+强算法”结合的产物。大模型通常是在大规模无标注数据上进行训练,学习出一种特征和规则。基于大模型进行应用开发时,将大模型进行微调,如在下游特定任务上的小规模有标注数据进行二次训练,或者不进行微调,就可以完成多个应用场景的任务。

大模型是辅助式人工智能向通用性人工智能转变的坚实底座:大模型增强了人工智能的泛化性、通用性,生产水平得到质的飞跃,过去分散化模型研发下,单一AI应用场景需要多个模型支撑,每个模型需要算法开发、数据处理、模型训练、参数调优等过程。大模型实现

了标准化AI研发范式,即简单方式规模化生产,具有“预训练+精调”等功能,显著降低AI开发门槛,即“低成本”和“高效率”。

算力是打造大模型生态的必备基础,服务器是算力的载体:算力是训练大模型的底层动力源泉,一个优秀的算力底座在大模型(AI算法)的训练和推理具备效率优势;服务器是算力的底层载体,包含CPU、GPU、内存、硬盘、网卡等,在ChatGPT中具有举足轻重的作用,算力是服务器通过对数据进行处理后实现结果输出的一种能力。

除了对低延迟低功耗算力的性能需求,在服务器的种类上也产生了多样化、细分化的场景应用需求。各行业与人工智能技术的深度结合及应用场景的不断成熟与落地,使人工智能芯片朝着多元化的方向发展,为了迎合芯片的多元化,服务器的类型也将越来越丰富,并适用越来越多的行业应用场景。根据IDC在2021年的统计,预计到2025年中国加速服务器市场规模将达到108.6亿美元,且2023年仍处于中高速增长期,增长率约为20%。

1)训练环节:通过标记过的数据来训练出一个复杂的神经网络模型,使其能够适应特定的功能,模型具有一定的通用性,以便完成各种各样的学习任务。该环节需要处理海量的数据,注重绝对的计算能力。

2)推理环节:利用训练好的模型,使用新数据推理出各种结论。借助神经网络模型进行运算,利用输入的新数据来一次性获得正确结论的过程。该环节对算力要求比训练环节略低,但注重综合指标,单位能耗算力、时延、成本等都要考虑。

训练对算力要求更高:2021年中国AI服务器推理负载占比约55.5%,未来有望持续提高;训练对芯片算力要求更高,推理对算力的要求偏低。

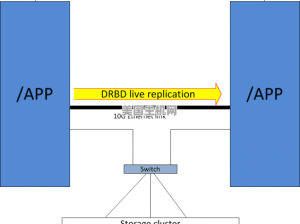

服务器架构随负载量扩张而不断优化:服务器架构经历了从传统单一模式到集群模式,再到分布式架构的优化过程。传统单一模式,服务器诞生初期将所有功能汇集在同一个系统,缺点为不便于维护、横向拓展性不佳;因此集群模式诞生,这种集群模式将同一项目放在多个服务器上,有效缓解用户访问量大的压力,但由于各个服务器间功能重复却缺乏协同,系统维护成本仍然较高,且增加了用户重复登陆问题,因此服务器架构进化到分布式模式。在分布式架构中,整个系统按照不同功能拆分为多个单一功能的子模块,每个模块被放到不同服务器中相互协作,共同组成服务器网络,能够有效解决功能耦合度高等问题且代码复用性高。

1、服务器的组成:服务器主要由主板、内存、CPU、磁盘、网卡、显卡、电源、主机箱等硬件设备组成;其中CPU、内部存储和外部存储是组成核心部件。

CPU处理器:负责整个服务器的运算与控制,相当于人的大脑,是直接影响到服务器性能的核心部件。单台服务器可由多个CPU组成,一般服务器CPU个数多为2-4颗,也可有单颗的;虚拟化主机CPU有4-8颗的。CPU越多服务器性能越高。CPU的核数一般都是四核。

内部存储:是CPU和硬盘之间的缓冲设备,是临时存储器(作用是临时存放数据),程序在运行的时候,都会调度到内存中运行,服务器关闭或程序关闭之后数据将自动从内存中释放掉。

外部存储:永久存放数据的存储器,其中常用的硬盘有300GB,500GB,1TB,3TB,4TB等。硬盘类型分机械硬盘,固态硬盘两种。

2、硬件成本构成:以一台通用服务器为例,CPU(主板或芯片组)占比最高,大约占成本50%以上,内存(内部存储+外部存储)占比约为20%。

X86架构服务器仍占绝对优势,ARM架构服务器潜力巨大:根据市场应用占比把服务器分为X86服务器和非X86服务器,目前使用X86架构的服务器CPU仍然占据绝对优势。根据芯八哥数据,按照2021年统计数据,X86架构市场占比高达97%,ARM占比仅为2.07%,Power BI占比为0.27% ,但以ARM为代表的RISC结构近年来增长迅猛,尤其国内诞生了以华为海思、阿里平头哥为代表芯片企业。

X86和ARM各具优势:ARM体积小、低功耗、低成本、执行更加高效、指令长度固定,然而在性能上不及X86,如果ARM要在性能上接近X86,就需要极高的频率,从而带来较高能耗;X86单条指令功能强大且指令数相对较小、带宽要求低,然而缺点在于寻址范围小、部分计算机利用率不高、执行速度慢。

ARM加速迭代,国产生态迎新机遇:根据TrendForce预测,随着云数据中心增长,预计到2025年,ARM架构在数据中心服务器市场渗透率将达到22%;ARM在服务器的市场崭露头角,早在2008年高通、博通、微软、华为、飞腾等,也陆续开发了各自的ARM服务器CPU,2019年,随着着ARM的Neoverse平台路线图的推出,服务器市场份额渗透率得到质的提升;国产生态迎新机遇,X86生态依然被AMD和英特尔垄断,而ARM架构随着国产生态和技术逐渐成熟,迎来国产替代的新机遇。

根据IDC数据,2021年全球服务器市场规模为992亿美元,同比增长9.01%,中国市场规模约251亿美元,近年来占全球比重呈现快速上升趋势,已成为全球最主要的服务器增长市场。此外,公有云作为国内外数据流量的重要抓手,服务器同样彰显其重要算力底座,存在巨大成长空间。

我国服务器单台均价接近全球均价:2021年全球服务器平均单价高达7328美元/台,我国市场也达到6415美元/台,我国服务器价格呈现上升状态,并且接近全球服务器平均价格。

人工智能应用场景下的加速计算服务器是中国服务器的核心驱动力:根据IDC的数据,随着智能应用正不断深入,从碎片化过渡到深度融合的一体化,从单点转换为多元化的应用场景,在金融、制造、能源和公共事业等行业体现尤为显著。2021上半年,中国加速计算服务器市场达到24亿美元,同比增长85.1%,此外,中国2021年H1服务器排名前五的厂商分别为浪潮(000977)、新华三、华为、戴尔、联想。此外,根据IDC的预测,未来中国整体服务器的复合增长率为12.7%,2025年中国服务器市场规模预计将达到424.7亿美元.

随着大数据、云计算、人工智能等技术的成熟与在各行各业的应用,AI服务器价值凸显;1、硬件架构,相较于通用服务器,AI服务器是采用异构形式的服务器,在异构方式上可以根据应用的范围采用不同的组合方式,如CPU+GPU、CPU+TPU、CPU+其他的加速卡等;2、加速卡数量: 通用服务器一般是单路或多路CPU架构,而AI服务器需要承担大量的AI运算,一般配置四块及以上加速卡;3、独特设计,AI服务器由于对加速卡的独特需求,需要针对性的对于系统结构、散热等做专门的设计,才能满足AI服务器需求。

AI芯片是AI算力的“心脏”,GPU价值凸显:伴随数据海量增长,算法模型趋向复杂,处理对象异构,计算性能要求高,AI 芯片在人工智能的算法和应用上做针对性设计,可高效处理人工智能应用中日渐多样繁杂的计算任务。在人工智能不断扩大渗透的数字时代,芯片多元化展现出广阔的应用前景,通过不断演进的架构,为下一代计算提供源源不断的动力源泉。

GPU作为AI芯片的主力军,正大放异彩:AI芯片主要包括图形处理器(GPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)、神经拟态芯片(NPU)等。人工智能深度学习需要异常强大的并行处理能力,GPU相比于CPU更擅长于并行计算能力,正在大放异彩。根据IDC的数据,2021年H1中国人工智能芯片,GPU占比最多为91.90%。

GPU服务器优势显著:GPU服务器超强的计算功能可应用于海量数据处理方面的运算,如搜索、大数据推荐、智能输入法等,相较于通用服务器,在数据量和计算量方面具有成倍的效率优势。此外,GPU可作为深度学习的训练平台,优势在于:1、GPU服务器可直接加速计算服务,亦可直接与外界连接通信;2、GPU服务器和云服务器搭配使用,云服务器为主,GPU服务器负责提供计算平台;3、对象存储 COS 可以为 GPU 服务器提供大数据量的云存储服务。

根据Wind及芯语的数据,AI服务器相较于高性能服务器、基础服务器在芯片组(CPU+GPU)的价格往往更高,AI服务器(训练)芯片组的成本占比高达83%、AI服务器(推理)芯片组占比为50%,远远高于通用服务器芯片组的占比。

浪潮通用服务器浪潮英信服务器NF5260M6搭载第三代英特尔®至强®可扩展处理器的一款2U双路机架式服务器,可支持1-2个支持1到2个英特尔® 至强® 第三代可扩展处理器,根据Intel官网数据,此款处理器建议零售价为9359美元,折合人民币约65000元。

浪潮AI处理器浪潮NF5488A5是一款浪潮自研的具有超强算力的AI服务器,性能领先。在4U空间内支持8颗第三代NVLink的NVIDIA A800 GPU,搭载2颗支持PCIe4.0的AMD EPYC 7002/7003 处理器,可提供极致训练性能和超高数据吞吐,广泛适用于图像、视频、语音识别、金融分析、智能客服等典型AI应用场景,根据天极网和中关村在线网数据,该款AMD(CPU)售价为8880美元,折合人民币约62000元,该款GPU售价为104000元。

AI服务器采用异构形式,按芯片类型可分为CPU+GPU、CPU+FPGA、CPU+ASIC等组合。目前GPU依然是实现数据中心加速的首选,其他非GPU芯片应用逐渐增多,IDC预计到2025年其他非GPU芯片占比超过20%。一般来说,ASIC的性能最好,但是可编程性和灵活性较弱;在训练或者通用情况下,GPU则是更好的选择。

参数量与算力需求呈正比,据ARK Invest预测,GPT-4参数量最高达15000亿个,则GPT-4算力需求最高可达31271 PFlop/s-day;与此同时,国内外厂商加速布局大模型,其参数量均达到千亿级别,同步带动算力需求爆发式增长。以GPT-4为例,为满足算力需要近千台浪潮NF5688M6服务器。

具备服务器能力的厂商:中科曙光(603019)、浪潮信息(000977)、拓维信息(002261)、神州数码(000034)、工业富联(601138)、紫光股份(000938).

具备算力芯片的厂商:寒武纪(688256)、海光信息(688041)、龙芯中科(688047)、景嘉微(300474)。

风险提示:国外制裁范围扩大的风险;国内厂商发展不及预期的风险;下游市场需求不及预期的风险;版权、伦理和监管风险等。